关于搜索引擎的6大超链接分析算法研究

万维网WWW(World Wide Web)是一个巨大的,分布全球的信息服务中心,正在以飞快的速度扩展。据马海祥了解在1998年WWW上就已经拥有约3.5亿个文档,每天增加约1百万的文档,不到9个月的时间文档总数就会翻一番。WEB上的文档和传统的文档比较,有很多新的特点,它们是分布的,异构的,无结构或者半结构的,这就对传统信息检索技术提出了新的挑战。

传统的WEB搜索引擎大多数是基于关键字匹配的,返回的结果是包含查询项的文档,也有基于目录分类的搜索引擎,这些搜索引擎的结果并不令人满意。有些站点有意提高关键字出现的频率来提高自身在搜索引擎中的重要性,破坏搜索引擎结果的客观性和准确性。

另外,有些重要的网页并不包含查询项。搜索引擎的分类目录也不可能把所有的分类考虑全面,并且目录大多靠人工维护,主观性强,费用高,更新速度慢。

许多研究者发现,WWW上超链结构是个非常丰富和重要的资源,如果能够充分利用的话,可以极大的提高检索结果的质量。

基于这种超链分析的思想,Sergey Brin和Lawrence Page在1998年提出了PageRank算法,同年J. Kleinberg提出了HITS算法,其它一些学者也相继提出了另外的链接分析算法,如SALSA,PHITS,Bayesian等算法。这些算法有的已经在实际的系统中实现和使用,并且取得了良好的效果。在此,马海祥就按照时间顺序详细的为大家剖析一下各种链接分析算法:

一、WEB超链分析算法

对于WEB超链分析算法,马海祥就从PageRank算法、HITS算法、SALSA算法、PHITS算法、贝叶斯算法和Reputation算法来为大家解说一下:

1、Google和PageRank算法

搜索引擎Google最初是斯坦福大学的博士研究生Sergey Brin和Lawrence Page实现的一个原型系统,现在已经发展成为WWW上最好的搜索引擎之一。Google的体系结构类似于传统的搜索引擎,它与传统的搜索引擎最大的不同处在于对网页进行了基于权威值的排序处理,使最重要的网页出现在结果的最前面。

Google通过PageRank元算法计算出网页的PageRank值(具体可查看马海祥博客的《pr值是什么》相关介绍),从而决定网页在结果集中的出现位置,PageRank值越高的网页,在结果中出现的位置越前。

(1)、PageRank算法

据马海祥博客了解PageRank算法是基于下面2个前提:

前提1:一个网页被多次引用,则它可能是很重要的;一个网页虽然没有被多次引用,但是被重要的网页引用,则它也可能是很重要的;一个网页的重要性被平均的传递到它所引用的网页。这种重要的网页称为权威(Authoritive)网页。

前提2:假定用户一开始随机的访问网页集合中的一个网页,以后跟随网页的向外链接向前浏览网页,不回退浏览,浏览下一个网页的概率就是被浏览网页的PageRank值。

简单PageRank算法描述如下:u是一个网页,![]() 是u指向的网页集合,

是u指向的网页集合,![]() 是指向u的网页集合,

是指向u的网页集合,![]() 是u指向外的链接数,显然 =

是u指向外的链接数,显然 =![]() |

|![]() | ,c是一个用于规范化的因子(Google通常取0.85),(这种表示法也适用于以后介绍的算法)则u的Rank值计算如下:

| ,c是一个用于规范化的因子(Google通常取0.85),(这种表示法也适用于以后介绍的算法)则u的Rank值计算如下:

![]()

这就是算法的形式化描述,也可以用矩阵来描述此算法,设A为一个方阵,行和列对应网页集的网页。如果网页i有指向网页j的一个链接,则![]() ,否则

,否则![]() =0。设V是对应网页集的一个向量,有V=cAV,V为A的特征根为c的特征向量。实际上,只需要求出最大特征根的特征向量,就是网页集对应的最终PageRank值,这可以用迭代方法计算。

=0。设V是对应网页集的一个向量,有V=cAV,V为A的特征根为c的特征向量。实际上,只需要求出最大特征根的特征向量,就是网页集对应的最终PageRank值,这可以用迭代方法计算。

如果有2个相互指向的网页a,b,他们不指向其它任何网页,另外有某个网页c,指向a,b中的某一个,比如a,那么在迭代计算中,a,b的rank值不分布出去而不断的累计。如下图所示:

![]()

为了解决这个问题,Sergey Brin和Lawrence Page改进了算法,引入了衰退因子E(u),E(U)是对应网页集的某一向量,对应rank的初始值,算法改进如下:

![]()

其中,![]() =1,对应的矩阵形式为V’=c(AV’+E)。

=1,对应的矩阵形式为V’=c(AV’+E)。

另外还有一些特殊的链接,指向的网页没有向外的链接。PageRank计算时,把这种链接首先除去,等计算完以后再加入,这对原来计算出的网页的rank值影响是很小的。

Pagerank算法除了对搜索结果进行排序外,还可以应用到其它方面,如估算网络流量,向后链接的预测器,为用户导航等(具体可查看马海祥博客的《pr的计算公式及影响因素》详细介绍)。

(2)、算法的一些问题

Google是结合文本的方法来实现PageRank算法的,所以只返回包含查询项的网页,然后根据网页的rank值对搜索到的结果进行排序,把rank值最高的网页放置到最前面,但是如果最重要的网页不在结果网页集中,PageRank算法就无能为力了,比如在Google中查询search engines,像Google,Yahoo,Altivisa等都是很重要的,但是Google返回的结果中这些网页并没有出现。

同样的查询例子也可以说明另外一个问题,Google和Yahoo都是WWW上最受欢迎的网页,如果出现在查询项car的结果集中,一定会有很多网页指向它们,就会得到较高的rank值,事实上他们与car不太相关。

在PageRank算法的基础上,其它的研究者提出了改进的PageRank算法。华盛顿大学计算机科学与工程系的Matthew Richardson和Pedro Dominggos提出了结合链接和内容信息的PageRank算法,去除了PageRank算法需要的前提2,增加考虑了用户从一个网页直接跳转到非直接相邻的但是内容相关的另外一个网页的情况。

斯坦大学计算机科学系Taher Haveliwala提出了主题敏感(Topic-sensitive)PageRank算法。斯坦福大学计算机科学系Arvind Arasu等经过试验表明,PageRank算法计算效率还可以得到很大的提高。

2、HITS算法及其变种

PageRank算法中对于向外链接的权值贡献是平均的,也就是不考虑不同链接的重要性。而WEB的链接具有以下特征:

①、有些链接具有注释性,也有些链接是起导航或广告作用,有注释性的链接才用于权威判断。

②、基于商业或竞争因素考虑,很少有WEB网页指向其竞争领域的权威网页。

③、权威网页很少具有显式的描述,比如Google主页不会明确给出WEB搜索引擎之类的描述信息。

可见平均的分布权值不符合链接的实际情况,J. Kleinberg提出的HITS算法中引入了另外一种网页,称为Hub网页,Hub网页是提供指向权威网页链接集合的WEB网页,它本身可能并不重要,或者说没有几个网页指向它,但是Hub网页确提供了指向就某个主题而言最为重要的站点的链接集合,比一个课程主页上的推荐参考文献列表。

一般来说,好的Hub网页指向许多好的权威网页;好的权威网页是有许多好的Hub网页指向的WEB网页。这种Hub与Authoritive网页之间的相互加强关系,可用于权威网页的发现和WEB结构和资源的自动发现,这就是Hub/Authority方法的基本思想。

(1)、HITS算法

HITS(Hyperlink-Induced Topic Search)算法是利用Hub/Authority方法的搜索方法,算法如下:将查询q提交给传统的基于关键字匹配的搜索引擎.搜索引擎返回很多网页,从中取前n个网页作为根集(root set),用S表示。S满足如下3个条件:

①、S中网页数量相对较小。

②、S中网页大多数是与查询q相关的网页。

③、S中网页包含较多的权威网页。

通过向S中加入被S引用的网页和引用S的网页将S扩展成一个更大的集合T。

以T中的Hub网页为顶点集Vl,以权威网页为顶点集V2,Vl中的网页到V2中的网页的超链接为边集E,形成一个二分有向图SG=(V1,V2,E)。对V1中的任一个顶点v,用h(v)表示网页v的Hub值,对V2中的顶点u,用a(u)表示网页的Authority值。开始时h(v)=a(u)=1,对u执行I操作修改它的a(u),对v执行O操作修改它的h(v),然后规范化a(u),h(v),如此不断的重复计算下面的操作I,O,直到a(u),h(v)收敛。(证明此算法收敛可见 )

I操作:![]()

O操作:![]()

每次迭代后需要对a(u),h(v)进行规范化处理:

![]()

![]()

I操作反映了若一个网页由很多好的Hub指向,则其权威值会相应增加(即权威值增加为所有指向它的网页的现有Hub值之和)。

O操作反映了若一个网页指向许多好的权威页,则Hub值也会相应增加(即Hub值增加为该网页链接的所有网页的权威值之和)。

和PageRank算法一样,可以用矩阵形式来描述算法,这里省略不写。

HITS算法输出一组具有较大Hub值的网页和具有较大权威值的网页。

(2)、HITS算法的问题

据马海祥博客了解,HITS算法有以下几个问题:

①、实际应用中,由S生成T的时间开销是很昂贵的,需要下载和分析S中每个网页包含的所有链接,并且排除重复的链接。一般T比S大很多,由T生成有向图也很耗时。需要分别计算网页的A/H值,计算量比PageRank算法大。

②、有些时候,一主机A上的很多文档可能指向另外一台主机B上的某个文档,这就增加了A上文档的Hub值和B上文档的Authority,相反的情况也如此。

HITS是假定某一文档的权威值是由不同的单个组织或者个人决定的,上述情况影响了A和B上文档的Hub和Authority值。

③、网页中一些无关的链接影响A,H值的计算。在制作网页的时候,有些开发工具会自动的在网页上加入一些链接,这些链接大多是与查询主题无关的(具体可查看马海祥博客的《基于结构化数据的丰富网页摘要研究》相关介绍)。同一个站点内的链接目的是为用户提供导航帮助,也与查询主题不甚无关,还有一些商业广告,赞助商和用于友情交换的链接,也会降低HITS算法的精度。

④、HITS算法只计算主特征向量,也就是只能发现T集合中的主社区(Community),忽略了其它重要的社区。事实上,其它社区可能也非常重要。

⑤、HITS算法最大的弱点是处理不好主题漂移问题(topic drift),也就是紧密链接TKC(Tightly-Knit Community Effect)现象。如果在集合T中有少数与查询主题无关的网页,但是他们是紧密链接的,HITS算法的结果可能就是这些网页,因为HITS只能发现主社区,从而偏离了原来的查询主题。

⑥、用HITS进行窄主题查询时,可能产生主题泛化问题,即扩展以后引入了比原来主题更重要的新的主题,新的主题可能与原始查询无关。泛化的原因是因为网页中包含不同主题的向外链接,而且新主题的链接具有更加的重要性。

(3)、HITS的变种

HITS算法遇到的问题,大多是因为HITS是纯粹的基于链接分析的算法,没有考虑文本内容,继J. Kleinberg提出HITS算法以后,很多研究者对HITS进行了改进,提出了许多HITS的变种算法,主要有:

①、Monika R. Henzinger和Krishna Bharat对HITS的改进

对于上述提到的HITS遇到的第2个问题,Monika R. Henzinger和Krishna Bharat在中进行了改进。假定主机A上有k个网页指向主机B上的某个文档d,则A上的k个文档对B的Authority贡献值总共为1,每个文档贡献1/k,而不是HITS中的每个文档贡献1,总共贡献k。类似的,对于Hub值,假定主机A上某个文档t指向主机B上的m个文档,则B上m个文档对t的Hub值总共贡献1,每个文档贡献1/m。I,O操作改为如下

I 操作:![]()

O操作:![]()

调整后的算法有效的解决了问题2,称之为imp算法。

在这基础上,Monika R. Henzinger和Krishna Bharat还引入了传统信息检索的内容分析技术来解决4和5,实际上也同时解决了问题3。具体方法如下,提取根集S中的每个文档的前1000个词语,串连起来作为查询主题Q,文档Dj和主题Q的相似度按如下公式计算:

![]()

![]() ,

,![]() ,

,![]() =项i在查询Q中的出现次数,

=项i在查询Q中的出现次数,

![]() =项i在文档Dj中的出现次数,IDFi是WWW上包含项i的文档数目的估计值。

=项i在文档Dj中的出现次数,IDFi是WWW上包含项i的文档数目的估计值。

在S扩展到T后,计算每个文档的主题相似度,根据不同的阈值(threshold)进行刷选,可以选择所有文档相似度的中值,根集文档相似度的中值,最大文档相似度的分数,如1/10,作为阈值。

根据不同阈值进行处理,删除不满足条件的文档,再运行imp算法计算文档的A/H值,这些算法分别称为med,startmed,maxby10。

据马海祥了解在此改进的算法中,计算文档的相似度时间开销会很大。

②、ARC算法

IBM Almaden研究中心的Clever工程组提出了ARC(Automatic Resource Compilation)算法,对原始的HITS做了改进,赋予网页集对应的连结矩阵初值时结合了链接的锚(anchor)文本,适应了不同的链接具有不同的权值的情况。

ARC算法与HITS的不同主要有以下3点:

a、由根集S扩展为T时,HITS只扩展与根集中网页链接路径长度为1的网页,也就是只扩展直接与S相邻的网页,而ARC中把扩展的链接长度增加到2,扩展后的网页集称为增集(Augment Set)。

b、HITS算法中,每个链接对应的矩阵值设为1,实际上每个链接的重要性是不同的,ARC算法考虑了链接周围的文本来确定链接的重要性。考虑链接p->q,p中有若干链接标记,文本1<a href=”q”>锚文本</a>文本2,设查询项t在文本1,锚文本,文本2,出现的次数为n(t),则w(p,q)=1+n(t)。文本1和文本2的长度经过试验设为50字节。构造矩阵W,如果有网页i->j ,Wi,j=w(i,j),否则Wi,j=0,H值设为1,Z为W的转置矩阵,迭代执行下面3个的操作:

A=WH

H=ZA

规范化A,H

c、ARC算法的目标是找到前15个最重要的网页,只需要A/H的前15个值相对大小保持稳定即可,不需要A/H整个收敛,这样2中迭代次数很小就能满足,中指出迭代5次就可以,所以ARC算法有很高的计算效率,开销主要是在扩展根集上。

③、Hub平均(Hub-Averaging-Kleinberg)算法

Allan Borodin等在指出了一种现象,设有M+1个Hub网页,M+1个权威网页,前M个Hub指向第一个权威网页,第M+1个Hub网页指向了所有M+1个权威网页。显然根据HITS算法,第一个权威网页最重要,有最高的Authority值,这是我们希望的。

但是,根据HITS,第M+1个Hub网页有最高的Hub值,事实上,第M+1个Hub网页既指向了权威值很高的第一个权威网页,同时也指向了其它权威值不高的网页,它的Hub值不应该比前M个网页的Hub值高。因此,Allan Borodin修改了HITS的O操作:

O操作:![]() ,n是(v,u)的个数

,n是(v,u)的个数

调整以后,仅指向权威值高的网页的Hub值比既指向权威值高又指向权威值低的网页的Hub值高,此算法称为Hub平均(Hub-Averaging-Kleinberg)算法。

④、阈值(Threshhold—Kleinberg)算法

Allan Borodin等在中同时提出了3种阈值控制的算法,分别是Hub阈值算法,Authority阈值算法,以及结合2者的全阈值算法。

计算网页p的Authority时候,不考虑指向它的所有网页Hub值对它的贡献,只考虑Hub值超过平均值的网页的贡献,这就是Hub阈值方法。

Authority阈值算法和Hub阈值方法类似,不考虑所有p指向的网页的Authority对p的Hub值贡献,只计算前K个权威网页对它Hub值的贡献,这是基于算法的目标是查找最重要的K个权威网页的前提。

同时使用Authority阈值算法和Hub阈值方法的算法,就是全阈值算法。

3、SALSA算法

PageRank算法是基于用户随机的向前浏览网页的直觉知识,HITS算法考虑的是Authoritive网页和Hub网页之间的加强关系。

实际应用中,用户大多数情况下是向前浏览网页,但是很多时候也会回退浏览网页。基于上述直觉知识,R. Lempel和S. Moran提出了SALSA(Stochastic Approach for Link-Structure Analysis)算法,考虑了用户回退浏览网页的情况,保留了PageRank的随机漫游和HITS中把网页分为Authoritive和Hub的思想,取消了Authoritive和Hub之间的相互加强关系。

据马海祥博客了解,其具体算法如下:

①、和HITS算法的第一步一样,得到根集并且扩展为网页集合T,并除去孤立节点。

②、从集合T构造无向图G’=(Vh,Va,E)

Vh = {sh |s∈C and out-degree(s) > 0 } ( G’的Hub边)

Va = {sa |s∈C and in-degree(s) > 0 } (G’的Authority边)

E= { (sh , ra) |s->r in T }

这就定义了2条链,Authority链和Hub链。

③、定义2条马尔可夫链的变化矩阵,也是随机矩阵,分别是Hub矩阵H,Authority矩阵A。

![]()

![]()

④、求出矩阵H,A的主特征向量,就是对应的马尔可夫链的静态分布。

⑤、A中值大的对应的网页就是所要找的重要网页。

SALSA算法没有HITS中相互加强的迭代过程,计算量远小于HITS。SALSA算法只考虑直接相邻的网页对自身A/H的影响,而HITS是计算整个网页集合T对自身AH的影响。

实际应用中,SALSA在扩展根集时忽略了很多无关的链接,比如:

①、同一站点内的链接,因为这些链接大多只起导航作用。

②、CGI 脚本链接。

③、广告和赞助商链接。

据马海祥博客的试验结果表明,对于单主题查询java,SALSA有比HITS更精确的结果,对于多主题查询abortion,HITS的结果集中于主题的某个方面,而SALSA算法的结果覆盖了多个方面,也就是说,对于TKC现象,SALSA算法比HITS算法有更高的健壮性。

BFS(Backword Forward Step)算法

SALSA算法计算网页的Authority值时,只考虑网页在直接相邻网页集中的受欢迎程度,忽略其它网页对它的影响。HITS算法考虑的是整个图的结构,特别的,经过n步以后,网页i的Authority的权重是![]() ,为离开网页i的

,为离开网页i的![]() 的路径的数目,也就是说网页j<>i,对i的权值贡献等于从i到j的

的路径的数目,也就是说网页j<>i,对i的权值贡献等于从i到j的![]() 路径的数量。如果从i到j包含有一个回路,那么j对i的贡献将会呈指数级增加,这并不是算法所希望的,因为回路可能不是与查询相关的。

路径的数量。如果从i到j包含有一个回路,那么j对i的贡献将会呈指数级增加,这并不是算法所希望的,因为回路可能不是与查询相关的。

因此,Allan Borodin等提出了BFS(Backward Forward Step)算法,既是SALSA的扩展情况,也是HITS的限制情况。基本思想是,SALSA只考虑直接相邻网页的影响,BFS扩展到考虑路径长度为n的相邻网页的影响。

在BFS中,![]() 被指定表示能通过

被指定表示能通过![]() 路径到达i的结点的集合,这样j对i的贡献依赖就与j到i的距离。BFS采用指数级降低权值的方式,结点i的权值计算公式如下:

路径到达i的结点的集合,这样j对i的贡献依赖就与j到i的距离。BFS采用指数级降低权值的方式,结点i的权值计算公式如下:

![]() =

=![]() |B(i)|+

|B(i)|+![]() |BF(i)| +

|BF(i)| +![]() |BFB(i)|+……+|

|BFB(i)|+……+|![]() |

|

算法从结点i开始,第一步向后访问,然后继续向前或者向后访问邻居,每一步遇到新的结点加入权值计算,结点只有在第一次被访问时加入进去计算。

4、PHITS算法

D. Cohn and H. Chang提出了计算Hub和Authority的统计算法PHITS(Probabilistic analogue of the HITS)。他们提出了一个概率模型,在这个模型里面一个潜在的因子或者主题z影响了文档d到文档c的一个链接,他们进一步假定,给定因子z,文档c的条件分布P(c|z)存在,并且给定文档d,因子z的条件分布P(z|d)也存在。

P(d) P(z|d) P(c|z) ![]() ,其中

,其中![]()

根据这些条件分布,提出了一个可能性函数(likelihood function)L,

![]() ,M是对应的连结矩阵。

,M是对应的连结矩阵。

然后,PHITS算法使用Dempster等提出的EM算法分配未知的条件概率使得L最大化,也就是最好的解释了网页之间的链接关系。算法要求因子z的数目事先给定。Allan Borodin指出,PHITS中使用的EM算法可能会收敛于局部的最大化,而不是真正的全局最大化。D. Cohn和T. Hofmann还提出了结合文档内容和超链接的概率模型。

5、贝叶斯算法

Allan Borodin等提出了完全的贝叶斯统计方法来确定Hub和Authoritive网页。假定有M个Hub网页和N个Authority网页(之前我也曾在马海祥博客上的《基于贝叶斯推断应用原理的过滤垃圾邮件研究》一文中跟大家介绍过),可以是相同的集合。每个Hub网页有一个未知的实数参数![]() ,表示拥有超链的一般趋势

,表示拥有超链的一般趋势![]() ,一个未知的非负参数,表示拥有指向Authority网页的链接的趋势。每个Authoritive网页j,有一个未知的非负参数

,一个未知的非负参数,表示拥有指向Authority网页的链接的趋势。每个Authoritive网页j,有一个未知的非负参数![]() ,表示j的Authority的级别。

,表示j的Authority的级别。

统计模型如下,Hub网页i到Authority网页j的链接的先验概率如下给定:

P(i,j)=Exp(![]()

![]() +

+![]() )/(1+Exp(

)/(1+Exp(![]()

![]() +

+![]() ))

))

Hub网页i到Authority网页j没有链接时,P(i,j)=1/(1+Exp(![]()

![]() +

+![]() ))

))

从以上公式可以看出,如果![]() 很大(表示Hub网页i有很高的趋势指向任何一个网页),或者

很大(表示Hub网页i有很高的趋势指向任何一个网页),或者![]() 和

和![]() 都很大(表示i是个高质量Hub,j是个高质量的Authority网页),那么i->j的链接的概率就比较大。

都很大(表示i是个高质量Hub,j是个高质量的Authority网页),那么i->j的链接的概率就比较大。

为了符合贝叶斯统计模型的规范,要给2M+N个未知参数(![]() ,

,![]() ,

,![]() )指定先验分布,这些分布应该是一般化的,不提供信息的,不依赖于被观察数据的,对结果只能产生很小影响的。Allan Borodin等在中指定

)指定先验分布,这些分布应该是一般化的,不提供信息的,不依赖于被观察数据的,对结果只能产生很小影响的。Allan Borodin等在中指定![]() 满足正太分布N(μ,

满足正太分布N(μ,![]() ),均值μ=0,标准方差δ=10,指定

),均值μ=0,标准方差δ=10,指定![]() 和

和![]() 满足Exp(1)分布,即x>=0,P(

满足Exp(1)分布,即x>=0,P(![]() >=x)=P(

>=x)=P(![]() >=x)=Exp(-x)。

>=x)=Exp(-x)。

接下来就是标准的贝叶斯方法处理和HITS中求矩阵特征根的运算。

简化的贝叶斯算法

Allan Borodin同时提出了简化的上述贝叶斯算法,完全除去了参数![]() ,也就不再需要正太分布的参数μ,δ了。计算公式变为:P(i,j)=

,也就不再需要正太分布的参数μ,δ了。计算公式变为:P(i,j)=![]()

![]() /(1+

/(1+![]()

![]() ),Hub网页到Authority网页j没有链接时,P(i,j)=1/(1+

),Hub网页到Authority网页j没有链接时,P(i,j)=1/(1+![]()

![]() )。

)。

Allan Borodin指出简化的贝叶斯产生的效果与SALSA算法的结果非常类似。

6、Reputation算法

上面的所有算法,都是从查询项或者主题出发,经过算法处理,得到结果网页。多伦多大学计算机系Alberto Mendelzon,Davood Rafiei提出了一种反向的算法,输入为某个网页的URL地址,输出为一组主题,网页在这些主题上有声望(repution)。比如输入,www.mahaixiang.cn,可能的输出结果是“java”,具体的系统我会在马海祥博客上为大家再做介绍,在此,就先不细说了。

给定一个网页p,计算在主题t上的声望,首先定义2个参数,渗透率![]() 和聚焦率

和聚焦率![]() ,简单起见,网页p包含主题项t,就认为p在主题t上:

,简单起见,网页p包含主题项t,就认为p在主题t上:

![]()

![]()

![]() 是指向p而且包含t的网页数目,

是指向p而且包含t的网页数目,![]() 是指向p的网页数目,

是指向p的网页数目,![]() 是包含t的网页数目。结合非条件概率,引入

是包含t的网页数目。结合非条件概率,引入![]() ,

,![]() ,

,![]() 是WEB上网页的数目。P在t上的声望计算如下:

是WEB上网页的数目。P在t上的声望计算如下:

![]()

指定![]() 是既指向p有包含t的概率,即

是既指向p有包含t的概率,即![]() ,显然有:

,显然有:![]()

我们可以从搜索引擎(如Altavista)的结果得到![]() ,

,![]() ,

,![]() ,WEB上网页的总数估计值

,WEB上网页的总数估计值![]() 某些组织会经常公布,在计算中是个常量不影响RM的排序,RM最后如此计算:

某些组织会经常公布,在计算中是个常量不影响RM的排序,RM最后如此计算:![]()

给定网页p和主题t,RM可以如上计算,但是多数的情况的只给定网页p,需要提取主题后计算。算法的目标是找到一组t,使得RM(p,t)有较大的值。TOPIC系统中是抽取指向p的网页中的锚文本的单词作为主题(上面已经讨论过锚文本能很好描述目标网页,精度很高),避免了下载所有指向p的网页,而且RM(p,t)的计算很简单,算法的效率较高。主题抽取时,还忽略了用于导航、重复的链接的文本,同时也过滤了停止字(stop word),如“a”,“the”,“for”,“in”等。

Reputation算法也是基于随机漫游模型的(random walk),可以说是PageRank和SALSA算法的结合体。

二、链接算法的分类及其评价

链接分析算法可以用来提高搜索引擎的查询效果,可以发现WWW上的重要的社区,可以分析某个网站的拓扑结构,声望,分类等,可以用来实现文档的自动分类等。归根结底,能够帮助用户在WWW海量的信息里面准确找到需要的信息,马海祥觉得这是搜索引擎正在迅速发展的研究领域。

上面我们从历史的角度总结了链接分析算法的发展历程,较为详细的介绍了算法的基本思想和具体实现,对算法的存在的问题也做了讨论。这些算法有的处于研究阶段,有的已经在具体的系统实现了。

在此,马海祥将这些算法大体分为以下几类:

①、基于随机漫游模型的,比如PageRank,Repution算法。

②、基于Hub和Authority相互加强模型的,如HITS及其变种。

③、基于概率模型的,如SALSA,PHITS。

④、基于贝叶斯模型的,如贝叶斯算法及其简化版本。

所有的算法在实际应用中都结合传统的内容分析技术进行了优化。

一些实际的系统实现了某些算法,并且获得了很好的效果,Google实现了PageRank算法,IBM Almaden Research Center 的Clever Project实现了ARC算法,多伦多大学计算机系实现了一个原型系统TOPIC,来计算指定网页有声望的主题。

AT&T香农实验室的Brian Amento在指出,用权威性来评价网页的质量和人类专家评价的结果是一致的,并且各种链接分析算法的结果在大多数的情况下差别很小。但是,Allan Borodin也指出没有一种算法是完美的,在某些查询下,结果可能很好,在另外的查询下,结果可能很差。所以应该根据不同查询的情况,选择不同的合适的算法。

基于链接分析的算法,提供了一种衡量网页质量的客观方法,独立于语言,独立于内容,不需人工干预就能自动发现WEB上重要的资源,挖掘出WEB上重要的社区,自动实现文档分类。但是也有一些共同的问题影响着算法的精度,具体分为以下几个原因:

1、根集的质量

根集质量应该是很高的,否则,扩展后的网页集会增加很多无关的网页,产生主题漂移,主题泛化等一系列的问题,计算量也增加很多。

算法再好,也无法在低质量网页集找出很多高质量的网页。

2、噪音链接

WEB上不是每个链接都包含了有用的信息,比如广告,站点导航,赞助商,用于友情交换的链接,对于链接分析不仅没有帮助,而且还影响结果。如何有效的去除这些无关链接,做个高质量链接也是算法的一个关键点(具体可查看马海祥博客的《如何做好网站的高质量链接》相关介绍)。

3、锚文本的利用

锚文本有很高的精度,对链接和目标网页的描述比较精确,上述算法在具体的实现中利用了锚文本来优化算法。如何准确充分的利用锚文本,对算法的精度影响很大。

4、查询的分类

每种算法都有自身的适用情况,对于不同的查询,应该采用不同的算法,以求获得最好的结果。因此,对于查询的分类也显得非常重要。

当然,这些问题带有很大的主观性,比如,质量不能精确的定义,链接是否包含重要的信息也没有有效的方法能准确的判定,分析锚文本又涉及到语义问题,查询的分类也没有明确界限。如果算法要取得更好的效果,在这几个方面需要继续做深入的研究,相信在不久的将来会有更多的有趣和有用的成果出现。

马海祥博客点评:

我们所探讨的这个基准在不同的搜索引擎之间会有很大的差异,有些搜索引擎看重网页中的链接,有些搜索引擎看重关键字和上下文,有些则重视元数据,但大部分的搜索引擎都会将这些因素以一定的比例组合在一起,组合的具体方法自然是各个搜索引擎的秘密。

本文发布于马海祥博客文章,如想转载,请注明原文网址摘自于https://www.mahaixiang.cn/seoyjy/612.html,注明出处;否则,禁止转载;谢谢配合!相关标签搜索: 搜索引擎 超链接 搜索引擎算法 超链接分析 搜索引擎研究

上一篇:什么是灰帽SEO技术?

下一篇:什么是绿帽SEO?

您可能还会对以下这些文章感兴趣!

-

百度索引量下降的原因及解决方法

作为一名专业的SEO人员,我们很多的时候都在研究站点中有多少页面可以作为搜索候选结果,也就是一个网站的索引量,所谓网站索引量,就是搜索引擎抓取你网站的数量,这能影响到网站收录率,是一个非常重要的SEO因素,索引量是流量的基础,索引量数据的每一个变动都拨动着……【查看全文】

-

落地页体验白皮书5.0解读:如何合理设置展开全文功能

本文解读文章深度剖析展开全文功能的设置要求。白皮书5.0提到”展开全文的设置必须具有文字标示,且功能实际可用;展开全文功能最多只能出现一次,但不可出现在落地页的首屏内容中(列表页除外);展开全文与广告等引导性内容要设置一定距离间隔,避免干扰用户操作。”如何设置展开全文按钮才更符合用户的体验习惯呢?这篇文章将为你答疑解惑。百度搜索用户研究团队的用户调研发现,搜索用户进入落地页的诉求是浏览页面全部内容,展开……【查看全文】

-

落地页体验白皮书5.0解读:什么样的顶部嵌入广告符合体验标准

《百度APP移动搜索落地页体验白皮书5.0》对页面广告的内容、形式、位置和面积的要求都做出了详细的说明,受到了全网开发者的广泛关注。关于白皮书5.0中最新提出的顶部嵌入广告标准”落地页首屏顶部允许嵌入不超过一屏面积10%的优质广告”,不少开发者对此提出疑问和反馈,本篇文章将对顶部嵌入优质广告要求做出具体解读:落地页首屏顶部允许嵌入优质广告的总体要求如下:面积:顶部嵌入广告面积必须小于首屏面积的10%。标识:广告位上有明……【查看全文】

-

基于用户投票的六大排名算法研究

随着互联网的发展,网站的数量也在随着成倍的增加着,就中国的互联网来说,根据中国互联网信息中心的数据显示,目前中国的网站数量每半年都会以接近10%的数量增长。这些大量的网站涌现,也就意味着我们已进入了信息大爆炸的时代。 而如今用户担心的已不再是信息太少,而……【查看全文】

-

网站SEO优化的分析诊断报告包含了哪些内容

SEO优化是针对搜索引擎规则做出优化以提高网站排名为目的的优化手段。其所需时间往往是长久性的,包括从网站域名、服务器、程序选取、网站结构、行业分析、竞争分析而切入的优化过程。而SEO诊断,在时间的要求上恰与其截然相反,所求目的完全与优化过程一致:提高网站友……【查看全文】

-

百度快照更新是什么意思?

最近发现有很多刚入SEO行业的新手对网站seo的技巧有很多的误区,比如网站快照不更新就代表网站被惩罚。关于这个观点我们先看看什么是百度快照,百度快照的作用是什么?我们有该如何让百度快照持续更新呢?快照即为Web Cache,可以翻译为网页缓存,当搜索引擎派出蜘蛛去对网站……【查看全文】

-

linux系统或windows+iis系统设置404页面方法

404页面通常是为用户访问了网站上不存在或已删除的页面,服务器返回404错误页面,告诉浏览者其所请求的页面不存在或链接错误,同时引导用户使用网站其他页面而不是关闭窗口离开,消除用户的疑虑。网站设置404页面后,如果网站出现死链接,搜索引擎蜘蛛爬行这类网址……【查看全文】

-

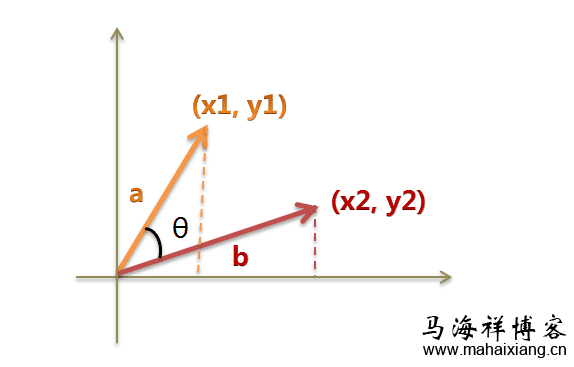

搜索引擎判定相似文章网页的原理

余弦相似性是指通过测量两个向量内积空间的夹角的余弦值来度量它们之间的相似性。0度角的余弦值是1,而其他任何角度的余弦值都不大于1;并且其最小值是 -1。从而两个向量之间的角度的余弦值确定两个向量是否大致指向相同的方向。两个向量有相同的指向时,余弦相似度的值……【查看全文】

-

揭秘搜索引擎中的反SEO作弊研究

从搜索引擎优化服务开始,分析了现在所存在的搜索引擎优化的作弊手段;然后提出了四种方法用来预防、破解作弊,并结合现实总结提出逐级分层审查刮度;最后结合Google搜索引擎,讨论并分析了Google搜索引擎的反作弊方法及其中的PR值算法……【查看全文】

-

SEO链轮是什么?

SEO链轮(SEO Link Wheels)是从国外引入国内的,一种比较新颖的SEO策略,是一种比较先进的网络营销方式。SEO链轮是指通过在互联网上建立大量的独立站点或是在各大门户网站上开设博客,这些独立站点或是博客群通过单向的、有策略、有计划紧密的链接,并都指向要优化的目标……【查看全文】

-

2011-2012年百度历次大更新数据分析

本篇文章记录了百度从2011年到2012年中旬百度大更新记录的文章。以下数据分析以站长之家官方提供的网站监控分析数据为蓝本,结合优词网等站点观察数据和一些 优秀SEO站长工具和软件的收集,并佐以自己手上二十几个站点作参考进行综合分析,基于统计学分析原理,以大量站……【查看全文】

-

百度移动搜索落地页体验白皮书4.0全文解读

进入移动互联网时代,百度搜索致力于提升搜索用户的浏览体验,营造健康的搜索生态。过去一年中,在百度搜索和全网资源提供者的共同努力下,移动搜索落地页广告问题已经得到了明显的改善。现在,百度搜索发布《百度移动搜索落地页体验白皮书4.0》,旨在继续与各内容生产……【查看全文】

-

Google搜索质量小组专业解答的25个SEO问题

2013年对于众多站长和SEO可以说是最为波折的一年,这一年百度出台了百度绿萝算法、百度石榴算法和百度绿萝算法2.0,而google也相继出台了谷歌EMD算法、熊猫算法、企鹅算法2.0和蜂鸟算法。作为一个站长或SEOer,你是否对这些算法还存在很多的疑惑,尤其对于靠做外贸产品……【查看全文】

-

网站最新SEO优化公式解析

网站seo优化公式 SEO=Clock=C1+L2+K3+O4 1、是一个积分符号,C=content,L=link,K=keywords,O=others。SEO就是一个长期的对时间积分过程,内容是核心; 2、C1丰富的内容是第一位的要素,按照原创、伪原创、转载依次排列内容的重要性满足用户体验; 3、L2链接的合理与……【查看全文】

-

404 Not Found错误页面的解决方法和注意事项

404页面就是当用户访问某网站时,点击了错误的链接时,所返回的页面。最常见的出错提示:404 Not Found。其目的就是告诉浏览者其所请求的页面不存在或链接错误,同时引导用户使用网站其他页面而不是关闭窗口离开。错误页面的文字可以自定义,有些网站没有设置404错误页面,或……【查看全文】

-

百度排名算法规则及SEO优化要点总结

做SEO目的其实就是为访客服务,满足用户的需求,想方设法的为了用户提供他们想要看的内容,而不是一味的最求最大利益化,其实百度只是一个展示的平台,只要你有了用户的青睐,你想达到的目标,自然也就水到渠成了,做SEO的核心就是要挖掘用户的力量,只有挖掘用户的力量……【查看全文】

-

《百度搜索优质内容指南》全文解读

今日,《百度搜索优质内容指南》在百度搜索学院悄悄地上线了,这是百度近两年,再次重新深度定义什么是百度搜索优质内容,对于SEO人员而言,特别是对于新站长而言,具有非常积极的指导意义,以免造成过多的资源浪费,给予了明确的指导规范的建议。百度搜索2020年全新发布了面向全网内容生产者的《百度搜索优质内容指南》,详细讲述了优质内容的标准,希望给广大内容生产者在生产优质内容时提供参考。关于优质内容的详细标准,请查看以下……【查看全文】

-

百度最新调整后的算法规则

最近闹得沸沸扬扬的百度6.22和6.28的K站事件到目前已经告一段落了,K站的主要原因已经渐渐明朗,以及百度将会对哪些类型的网站会做降权处理,现在也已经明朗化。针对各大站长漫长的着急等待,以及愤恨的心情,百度目前已经给出了较为明确的答案,那么百度规则和算法调整……【查看全文】

-

反向链接是什么意思

反向链接又叫导入链接(Backlinks),外部链接,是指外部网站有你的网址指向你的网站,其实就是在目标文档(网页)内部进行声明,要求目标文档指向自己(网页)的链接,通俗点讲,网页A上有一个链接指向网页B,则网页A上的链接是网页B的反向链接,换言之,常规链接在文……【查看全文】

阅读:2048关键词: 反向链接 日期:2012-08-14 -

如何分析网站是否真的被降权惩罚及解决方法

对于混迹于国内站长圈的朋友来说,每天起早贪黑发外链的网站被百度惩罚似乎在这几年已经是司空见惯的事了,所以很多时候网站流量、排名或者是收录有小幅度波动时,站长都会认为网站又被惩罚了,有到处的去抱怨。其实,很多情况都只是站长自己太过于敏感了而已,网站被百……【查看全文】

分类目录

互联网更多>>

云服务器的常规安全设置及基本安全策略

我们要保障云服务器数据安全,首先应树立正确的安全意识,从监控、入侵防御、数据备份等多方面做好安全措施,……

云服务器的常规安全设置及基本安全策略

我们要保障云服务器数据安全,首先应树立正确的安全意识,从监控、入侵防御、数据备份等多方面做好安全措施,……

基于贝叶斯推断应用原理的过滤垃圾邮件研究

随着电子邮件的应用与普及,垃圾邮件的泛滥也越来越多地受到人们的关注。而目前正确识别垃圾邮件的技术难度非……

基于贝叶斯推断应用原理的过滤垃圾邮件研究

随着电子邮件的应用与普及,垃圾邮件的泛滥也越来越多地受到人们的关注。而目前正确识别垃圾邮件的技术难度非……

互联网技术的50年发展回顾与分析

1998年至2008年是公认的互联网飞速发展的十年,无论是传输速率、网络规模、关键技术还是应用领域都经历了大幅的增……

互联网技术的50年发展回顾与分析

1998年至2008年是公认的互联网飞速发展的十年,无论是传输速率、网络规模、关键技术还是应用领域都经历了大幅的增……

SEO优化 更多>>

-

医疗行业开展品牌推广急需解决的1

医疗行业开展品牌推广急需解决的1

如今医疗行业要想在互联网上占有一席之地,就…… -

百度对站点Logo属性审核原则的具体要

百度对站点Logo属性审核原则的具体要

自百度搜索资源平台后台的站点属性设置开通上…… -

未来的站内SEO优化需要做些什么?

未来的站内SEO优化需要做些什么?

SEO说难不难,说简单也不是那么简单,很多人问…… -

预约未到诊患者的回访技巧及话术整

预约未到诊患者的回访技巧及话术整

很多朋友问预约是否有技巧,个人认为技巧是沉…… -

外贸企业网站常用的5个优化推广方法

外贸企业网站常用的5个优化推广方法

做海外推广不同国内的网站推广,因为在文化、…… -

百度公告:关于近期出现网站劫持用

百度公告:关于近期出现网站劫持用

近日,百度搜索技术团队发现,搜索结果中的部…… -

医疗行业该如何做免费营销推广

医疗行业该如何做免费营销推广

当前医疗网站越来越多,竞争也越来越激烈,各…… -

移动设备前端开发中viewport的理论及使

移动设备前端开发中viewport的理论及使

在移动设备上进行网页的重构或开发,首先得搞……

在服务器上设置网站IIS日志的方法步骤

在服务器上设置网站IIS日志的方法步骤 什么是白帽seo?

什么是白帽seo? 百度中文分词技术是什么?

百度中文分词技术是什么? O2O营销模式的深入解析

O2O营销模式的深入解析 运营数据中常见的数据陷阱

运营数据中常见的数据陷阱 如何撰写一份产品体验报告?

如何撰写一份产品体验报告? 移动设备Web App开发与调试的相关知识要点

移动设备Web App开发与调试的相关知识要点 知乎问答社区的运营机制

知乎问答社区的运营机制 传统行业该如何做电子商务?

传统行业该如何做电子商务? APP消息推送的误区与真相

APP消息推送的误区与真相 中小站长常用的5种赚钱方法

中小站长常用的5种赚钱方法 产品经理该如何做好产品的架构和流程

产品经理该如何做好产品的架构和流程 生活中的一些好点子教会你如何赚钱

生活中的一些好点子教会你如何赚钱

织梦dedecms列表页实现无限下拉加载效果的方法技巧

织梦dedecms列表页实现无限下拉加载效果的方法技巧  交互设计的三要素:目标、任务和行为

交互设计的三要素:目标、任务和行为  网站CSS代码优化的7个原则

网站CSS代码优化的7个原则